Comment installer une communauté Mastodon sur une instance virtuelle fonctionnant sur Ubuntu Focal Fossa

Mastodon est une application de gestion communautaire entièrement gratuite et libre sur vos instances virtuelles Scaleway Elements.

Au cours de ces deux dernières années, nous avons vécu deux canicules inédites sur Paris qui ont poussé les datacenters à leurs limites maximales de fonctionnement. L'année 2019 a été celle des records : des températures allant jusqu’à 43°C en juillet, et 38°C en août.

Ces vagues de chaleur ne sont pas sans conséquences et le réchauffement climatique remet en question les techniques usuelles de refroidissement des datacenters.

Avec l’adoption du cloud, l'informatique mondiale se déplace massivement dans les datacenters des fournisseurs de cloud, et ces derniers concentrent désormais une part très significative de l’empreinte énergétique de l’économie du numérique. Ils sont devenus plus que jamais des infrastructures critiques et vitales, dont la moindre défaillance a des conséquences désastreuses et un impact concret sur l’économie.

Bien que des progrès aient été réalisés ces dernières années, beaucoup reste à faire !

Le constat est simple : l'informatique a considérablement évoluée et dématerialise, mais ses fondations, les datacenters, sont restés bloqués 20 ans en arrière et n'ont pas évolué. La modernisation de leurs pratiques est un fort enjeux sanitaire, sociétal et environnemental. Ce secteur est sclérosé depuis deux décennies par des pratiques d’un autre temps.

Deux raisons à cela :

Par conséquent, afin de limiter les risques, et pour être conformes aux cahiers des charges des grands clients, les datacenters, même les plus récents, restent des copies conformes des anciens, sans apport innovant.

Alors que les serveurs modernes peuvent supporter une température constante de 30°C (conformément aux normes ASHRAE), les clients exigent encore une température de 20°C, sous contraintes de lourdes pénalités financières.

On continue donc à recourir massivement à la climatisation et à gâcher 30 à 40% de l’énergie d’un datacenter, juste pour le refroidir.

Il faut faire davantage d’efforts pour rassurer et informer les investisseurs, les donneurs d’ordre et les clients de l’évolution des technologies vers des pratiques plus vertueuses et plus en phase avec notre époque.

La course à la performance énergétique, enrobée par le vernis marketing, pousse les datacenters les plus efficients, salués par tout le marché, à des pratiques inavouables : le gâchis de millions de mètres cubes d’eau dans les tours de refroidissement, lequel est un processus caractérisé par des[ risques sanitaires]( https://solidarites-sante.gouv.fr/IMG/pdf/Rapport%5Fdu%5FCSHPF%5Fde%5Fnovembre%5F2001%5Frelatif%5Fa%5Fla%5Fgestion%5Fdu%5Frisque%5Flie%5Faux%5Flegionelles.pdf %28) et environnementaux considérables. Cette pratique est déjà fortement encadrée dans de nombreux pays mais non harmonisée à l’échelle européenne. La responsabilité environnementale de notre industrie doit reposer sur 3 piliers indissociables : usage de l’eau, efficience du datacenter et l’approvisionnement énergétique.

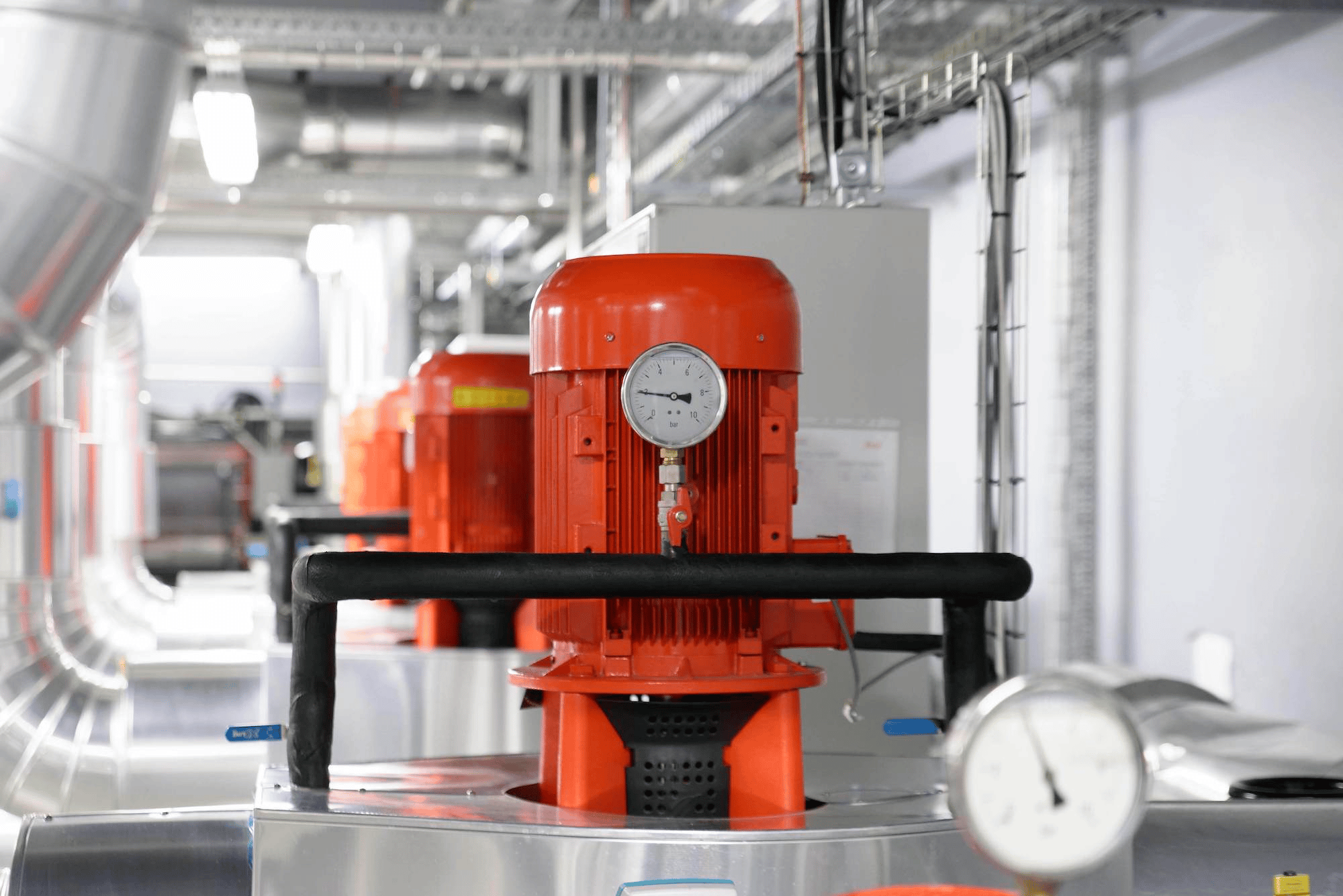

En plus d'être énergivores, les groupes frigorifiques sont soumis à des limites techniques lors des épisodes de canicules. Leurs limites maximales de fonctionnement (généralement 40°C en Europe), leur consommation électrique et leur efficacité (EER - Energy-Efficiency Ratio) dépendent directement et proportionnellement de la température extérieure. Autrement dit, pendant les périodes de fortes canicules, la climatisation fonctionne au maximum de sa capacité, avec un risque de panne élevé, une consommation d’énergie beaucoup plus élevée et une mauvaise efficacité.

Pour ces raisons là, pour tout propriétaire, responsable ou mainteneur de datacenter, ce sont des périodes difficiles et stressantes, où la moindre défaillance peut provoquer, par effet domino, l’arrêt total du datacenter.

On peut aussi se demander comment on est arrivé à un point où il est considéré comme acceptable de consommer 30 à 40% de l’énergie d’un datacenter rien qu’en climatisation en pleine hiver lorsque les réseaux d’électricité sont les plus sollicités et l’énergie la plus carbonée.

Sur les 650 milliards de kWh estimés en 2020 de consommation électrique des datacenters dans le monde, au moins 240 milliards sont inutiles et évitables rien que sur la climatisation !

Et pourtant des solutions innovantes existent depuis des années !

Les datacenters sont un terrain de jeu très fertile pour les innovations qui font du sens, et c’est à chacun d’entre nous, clients et acteurs du numérique, de changer nos habitudes.

Plutôt que de planter des arbres ou acheter des champs d’éoliennes, nous préférons réfléchir et innover là où nos efforts responsables peuvent avoir l’effet le plus marquant : l’utilisation de l’énergie, à sa source.

Lors de la conception et construction de DC5, nous avons voulu innover au lieu de créer davantage de copies conformes aux anciens datacenters qui, de part leurs limites techniques deviennent problématiques du fait du réchauffement climatique.

Plus de climatisation ni de groupes frigorifiques : juste quelques grammes d’eau évaporée dans l’air, quelques heures par an, par un procédé connu depuis l’antiquité (refroidissement adiabatique), suffisent à refroidir de près de 10°C l’air extérieur et donc maintenir des conditions stables et optimales de fonctionnement pour les précieux serveurs informatiques de nos clients et de notre Cloud public Elements.

Le procédé que Scaleway a industrialisé est simplissime, fonctionne avec du matériel standard, sans besoin de modification propriétaire du matériel informatique. Nous avons construit une chambre climatique pour étudier l’impact de toutes les conditions de température et d’humidité sur la quasi-totalité du matériel informatique disponible sur le marché.

Pour piloter le datacenter, ce sont 2 200 capteurs et points de mesure qui sont analysés en temps réel par un algorithme mathématique. Chaque 17 millisecondes, le datacenter s’adapte, se régule et s’optimise pour apporter à chaque serveur l’énergie et le refroidissement qui lui sont strictement nécessaires pour fonctionner.

L’unicité du système, le rend bien plus fiable que n’importe quel procédé mécanique. De plus, les économies d’énergie et d’eau sont massives, tout au long de l’année, il ne nécessite pratiquement aucun entretien et ne fait appel à aucun gaz frigorifique à effet de serre. Autrement dit, il est zéro-carbone !

Prise de risque insensée ? Innovation majeure ? Non, une technologie qui fait du sens pour chaque collaborateur Scaleway en tant que citoyen conscient et soucieux de son empreinte environnementale mais aussi en tant qu’acteur majeur du numérique soumis à de fortes contraintes techniques de fiabilité et de qualité.

Après deux canicules inédites pour la France, et trois ans de fonctionnement avec 100% de SLA, les résultats sont là et sont incontestables. À l’heure où les Etats et l’Europe se questionnent sur l’empreinte énergétique et écologique du numérique, il y a plus que jamais place, par incitation ou par contrainte, pour changer les habitudes et pour remettre l’innovation au coeur du sujet des “datacenters”.

Il est nécessaire de prendre conscience qu’il est plus important d’innover pour réduire l’empreinte énergétique et l’utilisation de l’eau à la source plutôt que de sortir des liasses de billets verts pour compenser.

Mastodon est une application de gestion communautaire entièrement gratuite et libre sur vos instances virtuelles Scaleway Elements.

Familink a récemment migré l’intégralité de son infrastructure d’AWS à Scaleway. Apprenez de leur retour d'expérience comment stocker vos données en Europe.

Pour mettre un terme à la crise climatique actuelle, il nous faut trouver des solutions immédiates. Nous partagerons quelques pistes dans cet article.